Immersion & Social Impact

Projets de recherche

r&d lab

AXE 2 : Immersion & Social Impact

Le jeu vidéo va bien au-delà de l’aspect divertissant. Les sujets développés à travers cet axe mettent l’humain au cœur d’intérêt, en explorant des projets innovants qui répondent aux besoins des entreprises, des sciences et de la société.

Ces projets nécessitent des compétences spécifiques ancrées dans l’identité de l’école, notamment en :

Simulation visuelle :

- Simulation et Modélisation temps-réel

- Visualisation scientifique & Infographie 2D/3D

- Jumeaux numériques

Interactivité et Immersion :

- Réalité Virtuelle / Augmentée

- Informatique affective

- Musique & Son dynamique et adaptatif

- Gamification et ludo-pédagogie

En raison de la nature pluri et interdisciplinaire de cet axe, qui s’applique à d’autres domaines comme la santé mentale, l’innovation pédagogique, la défense, l’écologie, la culture et le patrimoine; les projets réalisés sont orientés vers une application pratique et concrète, impliquant ainsi des collaborations avec nos partenaires académiques ou industriels.

Mots-clés : Visualisation 3D, e-learning, computer graphics, rendering, modélisation 3D, réalité virtuelle, UI & UX, émotions.

projets

les Thématiques

A – VISUALISATION SCIENTIFIQUE 3D & TEMPS-RÉEL

La visualisation 3D des données scientifiques dans des domaines variés (développement durable, médical, industriel, archéologique, etc.) permet de faciliter la compréhension des phénomes complexes, d’améliorer la présentation des modèles et d’aider à la prise de décision, notamment dans des environnements immersifs scénarisés.

Dans cette perspective, l’équipe d’ISART collabore avec différents laboratoires universitaires multidisciplinaires spécialisés dans la modélisation urbaine (UMR ESPACE), l’intelligence artificielle (LIP6) et le développement durable (IMREDD)…

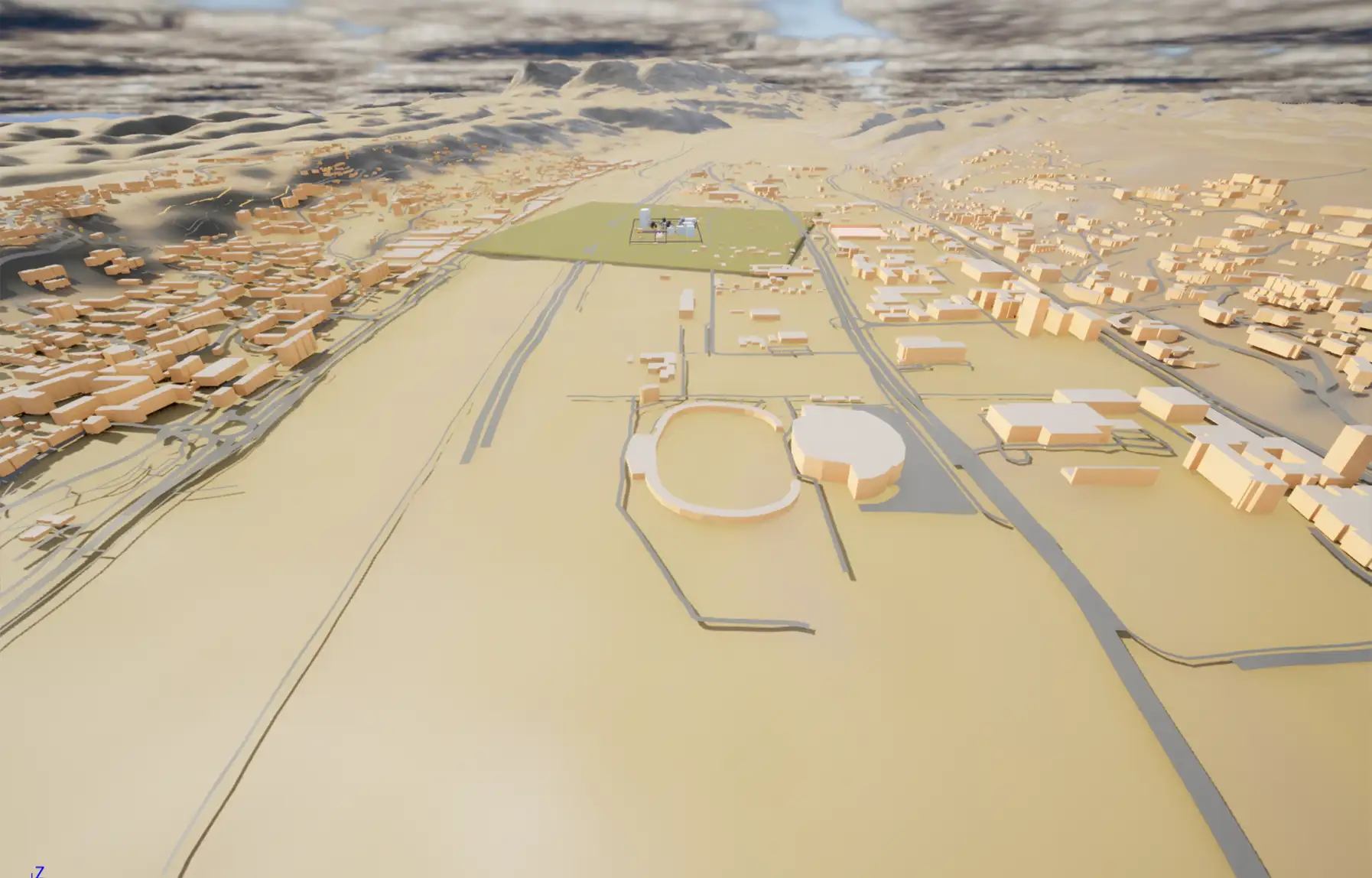

1 - Modélisation 3D d’un quartier de Nice : simulation de la pollution de l’air et du bruit

Contexte

Les jumeaux numériques sont essentiels pour le développement des smarts cities. Ils permettent de simuler la vie urbaine d’un quartier ou d’une ville et d’y scénariser différents événements (catastrophes naturelles, incendie, gestion de foule, etc.).

De tels jumeaux numériques facilitent aussi la prise de décision politique et urbanistique. Mais l’enjeu principal qui est au cœur des initiatives de type Smart City est finalement l’humain. Les aspects philosophiques et éthiques, de sécurité́ et de bien-être, de changement de comportement et d’usages, sont également pris en compte dans les smart cities pour construire un avenir urbain plus humain. L’enjeu sociétal : comment développer un territoire intelligent et résilient face à l’ensemble des problématiques environnementales ?

Sujet

L’objectif de ce projet est de développer un environnement virtuel 3D proposant un modèle urbain de l’écosystème du quartier du Parc Méridia de la ville de Nice en utilisant le moteur temps-réel Unreal Engine. Deux types de simulations y sont réalisées principalement : la pollution de l’air ainsi que la pollution sonore. Plusieurs paramètres sont pris en compte dans cette simulation tels que l’occlusion et la réflexion du son par les bâtiments, les taux d’émission variables de différents types de polluants atmosphériques en fonction de la vitesse de déplacement des véhicules, prise en compte du vent dans la dispersion des polluants. Les sources de pollution principales sont les véhicules roulants et certains bâtiments ainsi que les éventuelles foules de piétons. La végétation joue un rôle de fixateur des polluants.

Autres points forts du projet :

- topographie réelle issue du terrain de la région avec OpenStreeMap pour garantir la précision géographique de l’environnement et l’immersion.

- modélisation des assets 3D sur Maya / Blender afin de personnaliser les objets 3D incorporés dans la scène virtuelle

- modèles d’IA planificatrices pour la gestion de la foule et du trafic routier

- carte en temps réel et moyenné dans le temps de la pollution aérienne et sonore

Le résultat de ce projet permettra à l’EPA (établissement public d’aménagement) de prendre en compte les différents critères, contraintes, pour les considérer dans leurs aménagements.

Mots clés : Aide à la planification urbanistique, visualisation scientifique, temps-réel, modélisation 3D, pollution.

Partenaires : IMREDD (UMR ESPACE) – Université Côte d’Azur

Années : 2023/2025 (projet en cours)

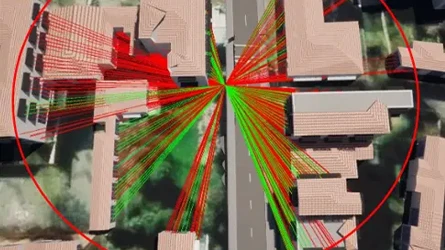

2 - Modélisation et Visualisation 3D de l’indice de visibilité dans la ville de Seclin (Lille)

Contexte

Le projet EMC2 “The Evolutive Meshed Compact City. A pragmatic transition pathway to the 15-minutes city for European metropolitan peripheries” est un projet collaboratif européen porté par G. FUSCO de l’UMR ESPACE, et rassemblant diverses universités, pôles de recherche, agences de développement et d’urbanisme.

Le projet EMC2 s’insère dans une logique de développement urbain qui vise à développer des villes plus agréables à vivre, plus sûres et plus écologiques.

À la différence du modèle originel se focalisant sur les grandes métropoles, le projet EMC2 analyse la ville du quart-d’heure en zone péri-urbaine, notamment pour les villes articulées autour un axe principal, linéaire ou en Y, et où tout piéton doit être à moins d’un quart d’heure à pied de cette rue principale.

Sujet

La présente étude se concentre sur le calcul de visibilité dans la ville du quart d’heure en zone péri-urbaine comme définie ci-dessus. Ce calcul de visibilité se base sur la théorie de Jane Jacobs « Eyes on the street ».

Les architectes urbanistes et chercheurs dans ce domaine travaillent en général avec des outils de modélisation 3D de la suite ArcGIS développée par Esri. Notamment CityEngine qui est un outil très utilisé dans l’exploitation de données géographiques qui est capable de donner des lignes de visibilité en 3D une par une ou de concevoir des cartes de visibilité en 2D, mais pas en 3D de manière généralisée.

En réponse à la problématique du calcul de la visibilité en 3D, il a été proposé d’utiliser un moteur de jeu vidéo, dans notre cas Unreal Engine. En effet, cette solution permet de récupérer les modèles 3D, puis de détecter les lignes de visibilité grâce aux collisions par lancement de rayons – technique inhérente aux moteurs de jeu vidéo et spécialement optimisée.

Mots clés : Modélisation Urbaine, Ville du quart-d’heure, Twin cities, Visualisation 3D

Partenaires : ESPACE, Université Côte d’Azur

Années : 2024/2025 (projet en cours)

3 - ImmerSim : simulation scientifique pour visualiser en 3D les impacts des activités humaines et de politiques sur le système Terre

Contexte

Face à la crise environnementale, comment mesurer l’impact de chaque nouvelle décision ou politique sur le « système Terre », composé des sociétés humaines, du climat et de la biodiversité ?

Il n’existe pas, aujourd’hui, une solution permettant de déterminer le plus scientifiquement possible quels seraient les comportements individuels et collectifs les plus dommageables ou vertueux. Une équipe du Laboratoire d’Informatique de Sorbonne Université (LIP6) a créé le projet TerraNeon afin de combler ce manque, en développant un outil d’aide à la décision basé sur une approche multi-agents (issue de l’intelligence artificielle collective) systémique. Cet outil permet de modéliser et simuler :

- les activités économiques (individus et entreprises)

- les activités humaines (individuelles et collectives)

- les réglementations et lois qui régissent la société

Pour profiter des avantages de TerraNeon, il est crucial de sensibiliser tous les acteurs de la société sur l’impact de leurs actions sur le climat. Cela peut être réalisé grâce à ImmerSim, outil de visualisation 3D (sous forme de jeu vidéo), qui offrira une immersion 3D des résultats des simulations multi-agents.

Sujet

Ce projet consiste à développer un environnement 3D – sous Unity – possédant une vue globale (échelle planétaire) et locale (échelle humaine) à la façon d’un « google earth ». L’utilisateur/joueur pourra ainsi mieux se rendre compte de l’impact de telle ou telle décision politique en matière de climat sur l’environnement et la biodiversité en se promenant à la surface du globe, dans les villes et les campagnes, à différentes échelles de temps.

Les jeux de données temporelles seront issues de TerraNeon. Les éléments de décors dans l’univers virtuel sont générés procéduralement pour tenir compte, de manière dynamique, de l’impact climatique en fonction des données issues de la simulation.

Mots clés : visualisation scientifique, temps-réel, modélisation 3D, génération procédurale , système multi-agents

Partenaire : projet en partenariat avec le LIP6 de la SU

Années : 2023/2024 (projet en cours)

4 - Visualisation scientifique 3D : culture et patrimoine

Dans le cadre de ce partenariat, divers sujets ont été explorés, en utilisant le moteur temps-réel Unreal Engine pour visualiser des données scientifiques dans les domaines biomécanique, archéologique, artistique et historique, etc. Parmi les projets réalisés :

- la reconstruction du théâtre antique d’Orange

- la maison de Molière

- des quartiers de Rome antique

- la création de visages à partir de données issues de crânes

Mots clés : Visualisation scientifique 3D, calcul scientifique, temps-réel, culture et patrimoine.

Partenaire : projet en partenariat avec l’ISCD de la SU

Projets terminés

B – SCIENCES COGNITIVES & SANTÉ NUMÉRIQUE

Les technologies de jeux vidéo jouent un rôle important dans le domaine de la santé mentale en raison de leur caractère immersif, le design, la narration, et les émotions, etc. Les jeux vidéo peuvent aider les individus à développer leurs capacités à se détendre, à gérer leurs émotions et à traiter des troubles cognitifs tels que l’axiété et la dépression. De plus, ils servent à sensibiliser les personnes sur des problèmes liés à la santé mentale.

C’est dans cette optique que le laboratoire d’ISART travaille en collaboration depuis 2021 avec le Cognition Behaviour Technology Lab (COBTEK) de l’Université Côte d’Azur pour définir et réaliser des projets de recherche multidisciplinaires exploitant le potentiel du jeu vidéo pour améliorer la santé mentale des individus.

1 - Enseigner la Relation soignant-soigné en psychiatrie du sujet âgé avec TeachMod

L’enseignement des compétences interpersonnelles, communication, savoir-être, comportements adaptés, aux étudiants en santé se révèle souvent difficile avec les méthodes traditionnelles.

Pour répondre à cet enjeu, l’application TeachModvr a été développée sous Unity3D comme un outil interactif utilisant la RA des composants visuels et interactifs pour faciliter l’enseignement et l’évaluation de bases relationnelles lors d’une consultation clinique avec le patient.

L’application disponible gratuitement, propose à ce jour deux scénarios (vidéos omnidirectionnelles 360°) orientés sur les dimensions psychologiques. Deux troubles cognitifs des patients ont été abordés : troubles de mémoire et de langages.

Plus de détails sont disponibles dans la publication IEEE CoG 2022.

L’application peut être téléchargée sur :

Mots clés : eE-learning, e-health, relation soignant-soigné, Unity3D

Année : 2021 (projet terminé)

2 - Régulation des émotions négatives chez les étudiants de manière ludo-pédagogique

La fréquence des symptômes dépressifs et anxieux chez les étudiants a connu une augmentation du fait de l’épidémie de COVID-19 (cours à distance, confinement et isolement etc.). De plus, les méthodes de régulation émotionnelle sont très peu enseignées en France. De ce fait, TeachMod RE, développée sous Unity3D, offre un univers virtuel 3D où l’apprenant incarne un avatar d’étudiant à la première personne pour augmenter l’immersion dans le jeu. Le scénario principal consiste à évaluer la pression engendrée par les examens avec différentes mises en situations.

Plusieurs questions à choix multiples sont affichées à l’étudiant dans le but d’étudier ses stratégies de régulation émotionnelle (suppression émotionnelle ou réévaluation cognitive). L’évolution des événements varie en fonction des choix précédents de l’utilisateur. Des informations théoriques basées sur la régulation émotionnelle sont également fournies. Plus de détails sont disponibles dans la publication IEEE CoG 2023.

L’application peut être téléchargée sur :

Mots clés : jeu éducationnel, Unity3D, régulation des émotions, scénarisation, environnement virtuel, immersion et interaction

Année : 2023 (projet terminé)

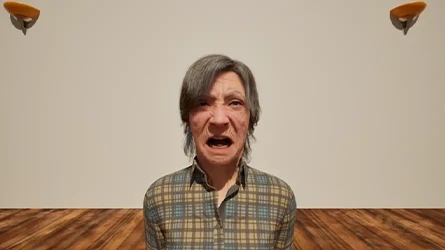

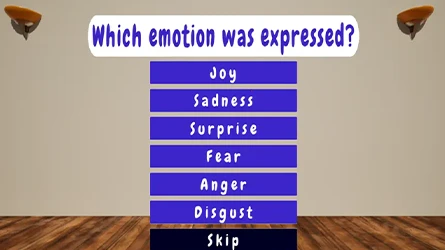

3 - Intevidi : les avatars ultra-réalistes peuvent-ils servir de base de données cliniquement validée pour la reconnaissance des émotions ?

Contexte

Les patients atteints de troubles cognitifs présentent souvent des difficultés à reconnaître les émotions et à interagir socialement.

Pour les évaluer, les professionnels de santé utilisent habituellement des photos statiques ou des acteurs.

Sujet

Ce projet s’inscrit dans une collaboration franco-italienne, autour des technologies immersives appliquées à l’étude des troubles cognitifs.

Nous utilisons des avatars ultra-réalistes Metahuman pour vérifier s’ils peuvent constituer une base de données d’expressions émotionnelles cliniquement validée.

Le développement repose sur Unreal Engine 5.5.

- Nous avons d’abord créé un tableau liant chaque point de rig facial à une unité d’action basée sur le FACS, pour garantir la validité des expressions générées.

- Ensuite, nous avons conçu des scènes 3D simples où des avatars présentent différentes émotions.

Après chaque séquence, les participants doivent identifier l’émotion et évaluer son réalisme. - Des vidéos d’acteurs réels sont aussi intégrées pour comparer les résultats. La prochaine étape sera une phase d’expérimentation clinique pour tester et valider notre hypothèse.

Mots clés : reconnaissance des émotions, affective computing, Metahuman, Unreal Engine

Partenaire : CoBTeK Université Côte d’Azur

Années : 2024/2025 (projet en cours)

C- RÉALITÉ VIRTUELLE & IHM

1 - CoVR : expériences immersives en réalité virtuelle avec le retour haptique

Contexte

Le retour haptique permet d’enrichir l’expérience d’un jeu en réalité virtuelle (VR) en engageant plusieurs sens (visuel, auditif, tactile), offrant ainsi une immersion multisensorielle riche.

À l’ISIR, une arène CoVR a été développée où les utilisateurs peuvent se déplacer et interagir avec des objets physiques sans l’utilisation de contrôleurs.

Cependant, les joueurs immergés à 360° peuvent être enclins à se distraire et à se déplacer n’importe où dans le monde virtuel 3D. Ceci représente des défis en termes de conception de jeu, surtout lorsque l’espace et les objets physiques sont limités, comme c’est le cas avec CoVR.

Comment pouvons-nous donc optimiser l’utilisation de l’espace et l’interaction avec les quelques éléments physiques disponibles de l’arène CoVR afin de proposer des expériences immersives, ludiques et captivantes qui exploitent pleinement le sens du toucher ?

Sujet

Le principal objectif de ce projet est de concevoir et mettre en œuvre un jeu en VR en Unity3D qui met en avant les capacités uniques de la plateforme CoVR afin d’offrir une expérience multisensorielle.

Un système robotisé présentant d’objets physiques (boutons, volant, étagère, etc.) est utilisé pour prédire la trajectoire de l’utilisateur dans l’arène, lui permettant ainsi d’interagir avec ces objets.

De plus, les utilisateurs peuvent ressentir différentes forces grâce aux fonctionnalités d’interaction homme-machine du CoVR, comme tirer, pousser, bloquer, toucher, déplacer, etc.

Étant donné les contraintes techniques, le premier scénario du jeu est relativement simple et dure entre 5 et 15 min. Il s’inspire du concept de “Fort-Boyard”, où les joueurs peuvent explorer différentes planètes en voyageant à bord d’une capsule spatiale à la recherche d’artefacts mystérieux.

Chaque planète visitée correspond à un niveau de jeu et possède ses propres défis et mécaniques de jeu. Les univers 3D varient d’une planète à l’autre afin d’offrir une diversité de décors et une immersion renouvelée.

Cette aventure est modulable et peut s’adapter à plusieurs situations (joueur seul, accompagné d’amis, etc.). De plus, la modularité de l’architecture du jeu permet d’ajouter facilement de nouvelles expériences et scénarios, permettant ainsi de le développer progressivement.

Mots clés : réalité virtuelle, retour haptique, interaction homme-machine, robotique

Partenaire : projet en partenariat avec l’ISIR de la SU

Années : 2023/2025 (projet terminé)

D – JEU VIDÉO & DÉFENSE

Les technologies temps réel issus du jeu vidéo offrent des plateformes puissantes pour la simulation interactive et l’entrainement immersif pour la défense (médecins militaires, sapeurs-pompiers, soldats, gendarmes etc.).

ISART mène de nombreux projets innovants, en mobilisant son expertise en ingénierie du jeu vidéo, en collaboration avec des institutions publiques telles que l’Académie Militaire de Saint-Cyr Coëtquidan, l’Académie Militaire de la Gendarmerie Nationale, l’Institut de Recherche Biomédicale des Armées (IRBA), l’Ecole Val-de-Grâce ou encore la Brigade Sapeurs Pompiers de Paris….

1 - Étude de l’effet de la pro-action sonore dans un jeu 3D

Contexte

Les travaux antérieurs menés sur un jeu de Tetris ont mis en évidence l’effet de la synchronisation de la musique sur la performance des joueurs. La désynchronisation du tempo dans le jeu semble aider les joueurs. D’autres études (sur d’autres jeux) rapportent un résultat inverse : chez eux, la synchronisation de la musique aide le joueur. Cependant, ces derniers ont synchronisé le son sur les actions souhaitées du joueur et non sur des évènements « stressants » du gameplay (chute des pièces, apparition d’un ennemi, etc…).

Hypothèse de l’étude : Est-ce que la synchronisation du son agit différemment en fonction de l’élément de gameplay utilisé comme référence ?

Autrement dit, nous souhaiterions déterminer si un son synchronisé sur les actions du joueur a un effet différent d’un son synchronisé sur les évènements du gameplay.

Sujet

Pour répondre à cette problématique, l’équipe de recherche d’ISART a travaillé avec l’équipe IA pour l’Ingénieire Comportementale (AIPIC) du Centre de Recherche de Coëtquidan. Les équipes ont développé avec le moteur Unity un jeu de tir sur PC offrant un univers militaire 3D à plusieurs niveaux. Le joueur incarne à la première personne un soldat franc-tireur qui doit viser des ennemis à des emplacements bien précis afin de marquer des points.

La synchronisation de la musique est réalisée soit sur :

- les actions désirées par les joueurs (mode exploration/surveillance ou mode combat) ;

- les évènements de gameplay correspondant aux difficultés à surmonter comme:

- cible de petite taille,

- ennemis éloignés, leur nombre et leur rapidité,

- obstacles,

- autres éléments distrayants la concentration du joueur.

Une étude préliminaire a été réalisée et publiée dans IEEE CoG 2024

Partenaire : École spéciale militaire de Saint-Cyr CreC

Années : 2022/2023